En ocasiones la ciencia avanza movida por la casualidad. Los casos de Barry Kidston y el de otros siete heroinómanos conocido como el de los adictos paralizados (The Case of the Frozen Addicts) ayudaron al descubrimiento del MPTP, una sustancia que ha permitido grandes avances en la lucha contra la enfermedad de Parkinson.

Barry Kidston, químico de 23 años, era adicto a las drogas. Usando sus conocimientos, sintetizó MPPP, un opiáceo similar a la heroína. En 1976, después de varios meses de administración intravenosa, en una urgencia, elaboró de nuevo el compuesto, pero acortó el método y algo salió mal. Tras varios días de consumo, ingresó en urgencias. Manifestaba mutismo, rigidez severa, debilidad, temblores, cara inexpresiva y sensibilidad alterada.

El equipo médico observó que los síntomas eran equivalentes a los que se producen en la enfermedad de Parkinson y le administró L-Dopa, medicación habitual en el Parkinson. Kidston mejoró parcialmente. Con el tiempo desarrolló tolerancia a la L-Dopa, manifestaba lentitud de pensamiento, se deprimió y siguió consumiendo drogas. 18 meses después murió víctima de una sobredosis de cocaína. La autopsia reveló una destrucción masiva de las neuronas de la sustancia nigra que usan la dopamina como neurotransmisor. El análisis de los restos de la dosis defectuosa revelaron la existencia de MPPP (el opiaceo deseado) junto con otras sustancias sin determinar claramente. Una inyección de la dosis en ratas produjo una parálisis parcial pero el equipo no fue capaz de reproducir los resultados completos (posteriormente se demostró que las ratas son resistentes al compuesto tóxico). Se publicó un estudio y el caso se olvidó.

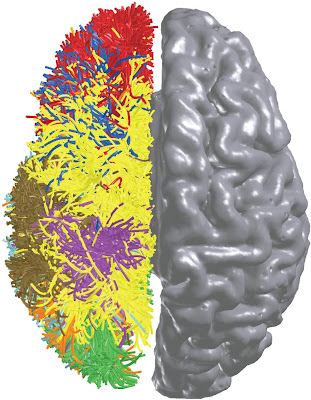

En 1817 el británico James Parkinson, publicó el famoso ensayo “La parálisis temblorosa” (The Shaking Palsy) en el que describía la vida de seis pacientes con agitación constante, rigidez y lentitud de movimientos. Más tarde, el neurólogo francés Charcot la denominó como Enfermedad de Parkinson. Afecta al 1% de la población mundial con mayor prevalencia en las personas mayores. El movimiento es el resultado de un sistema muy complejo de excitaciones e inhibiciones en el que interviene el cortex motor y otras estructuras subcorticales como los ganglios basales. Una de ellas, la sustancia nigra maneja un neurotransmisor llamado dopamina. La destrucción de neuronas de la sustancia nigra provoca Parkinson.

Una medicación habitual es la L-Dopa, un precursor de la dopamina que ayuda a que aumente la concentración de esta en el cerebro. Desafortunadamente, la L-Dopa tiene muchos efectos secundarios como exceso de movimientos, grades tics y alucinaciones. La enfermedad de Pakinson es exclusivamente humana y la posibilidad de contar con modelos animales de experimentación resultó un gran avance.

El caso de los adictos paralizados

En 1982 un joven ingresó en un hospital de California en estado de parálisis. Poco después lo hizo su novia y en distintos hospitales otros tres jóvenes. Eran incapaces de hablar, pero uno de ellos podía mover la mano. El equipo liderado por William Langston le dio un papel y un lápiz y el joven escribió “heroína”. Langston habló por TV alertando de una partida tóxica de heroína y dos nuevos casos aparecieron así como el vendedor de la droga que manifestó que era sintética. Investigaron la droga y resultó no ser heroína sino MPPP. Pero el MPPP no es tóxico de modo que no era el responsable del desastre. Alguien en el equipo recordó el caso de Barry Kidston y cotejaron ambas drogas. El análisis reveló una sustancia nueva MPTP, un subproducto indeseado de la síntesis de MPPP.El descubrimiento del MPTP ha supuesto un enorme avance en la lucha contra el Parkinson. De un lado demuestra que no es obligatoriamente hereditario sino que puede ser producido por agentes externos. Administrado en primates ha revelado que destruye la sustancia nigra como reveló la autopsia de Barry Kidston y ha resultado ser un excelente modelo animal para la investigación de fármacos contra la enfermedad. Langston escribió el libro The Case of the Frozen Addict y ha dedicado su vida al estudio del Parkinson.

Publicado originalmente en ALT1040